Aunque algunas empresas tecnológicas han comenzado a usar modelos de inteligencia artificial (IA) más pequeños y eficientes para reducir el consumo de energía, expertos advierten que aún falta mucho por hacer en términos de sostenibilidad y transparencia ambiental.

Modelos pequeños, pero sin suficiente conciencia energética

Empresas como Google y Microsoft declararon que sus funciones de búsqueda ya emplean modelos más ligeros cuando es posible, lo que puede significar respuestas más rápidas y menor consumo energético.

Sin embargo, Noman Bashir, becario de Informática e Impacto Climático del MIT Climate & Sustainability Consortium, señala que los proveedores no informan al usuario sobre cuánta energía consume cada consulta. Lo que prevalece, afirma, es la rapidez, con el objetivo de retener al usuario en la plataforma:

“Si ChatGPT empieza a responderte en cinco minutos, buscarás otra herramienta que lo haga más rápido”, explica.

Alexa y el uso intensivo de IA

Durante un evento en Nueva York, Daniel Rausch, vicepresidente de Alexa y Echo en Amazon, presentó la nueva versión de Alexa+, renovada con inteligencia artificial. Dijo que la IA generativa se utilizó en todo el proceso, desde la programación hasta las pruebas del asistente.

Este relanzamiento se enmarca en una tendencia creciente de dependencia tecnológica de la IA, pero también en un contexto de creciente preocupación por su huella de carbono.

El entorno físico sí importa

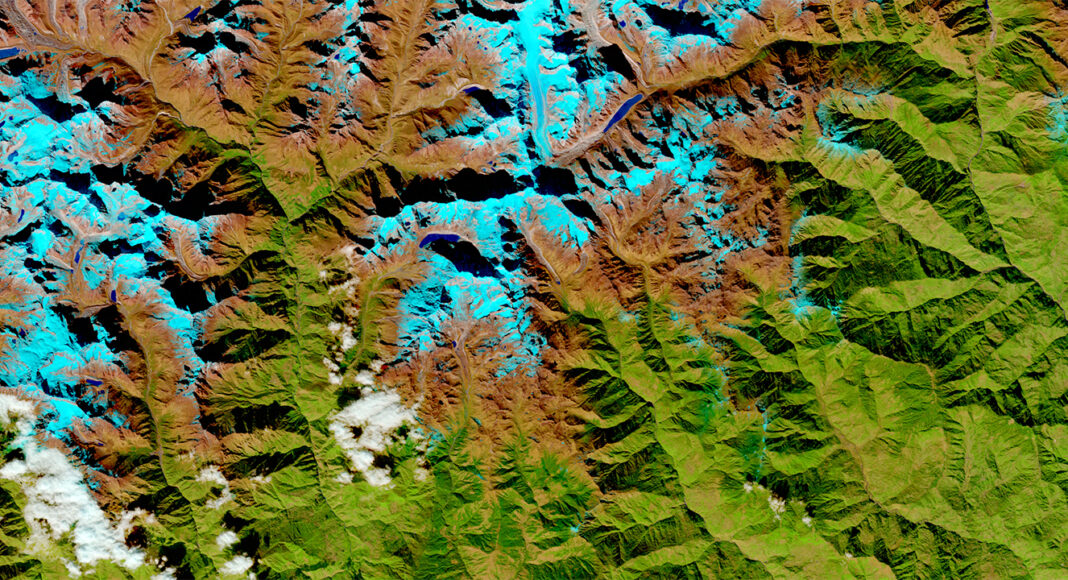

Bashir subraya que no basta con estudiar el consumo teórico de las consultas de IA. Factores como:

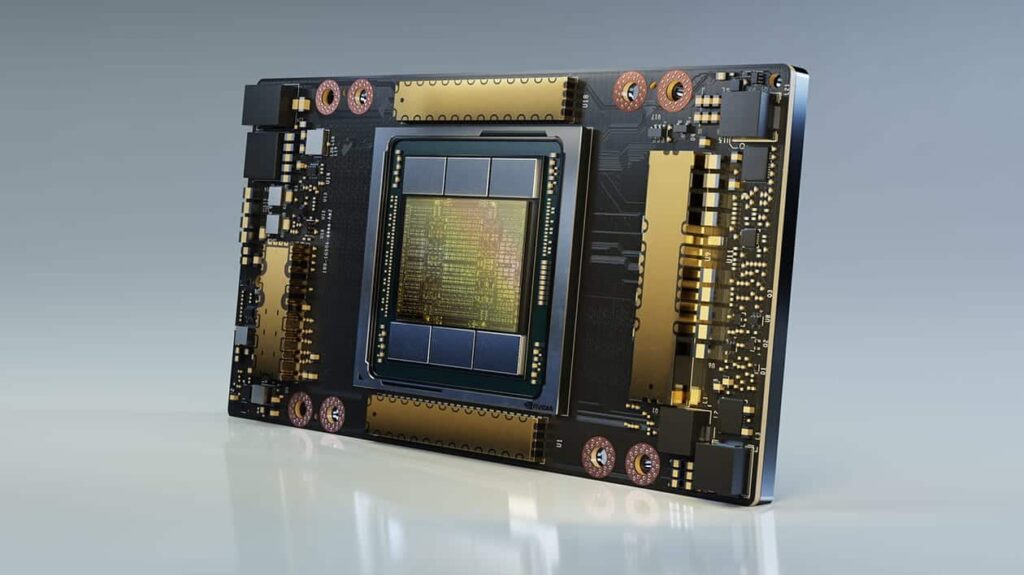

- El hardware, por ejemplo la GPU Nvidia A100, diseñada para cargas de IA pero de alto consumo energético.

- La infraestructura física: centros de datos con iluminación, refrigeración y equipos de red.

- Las fuentes de energía: algunas dependen de combustibles fósiles, otras de renovables.

Estas variables impactan directamente en la cantidad de emisiones generadas por la IA.

Comparar pruebas aisladas, dice Bashir, es como “pisar el acelerador de un auto suspendido y medir las revoluciones de la llanta como si eso indicara su eficiencia”.

Datos ocultos

Uno de los mayores desafíos es que las empresas no revelan cifras claras sobre el consumo energético de entrenar y actualizar modelos de IA. Incluso la célebre frase del CEO de OpenAI, Sam Altman, sobre que ChatGPT consume la misma energía que una bombilla, podría ser engañosa si no incluye el costo energético del entrenamiento de los modelos.

“Si tuviera una varita mágica, obligaría a cualquier empresa que lance un sistema de IA en producción a revelar su huella de carbono”, declaró la investigadora Luccioni.